Sử dụng mô hình Langchain ChatOpenAI

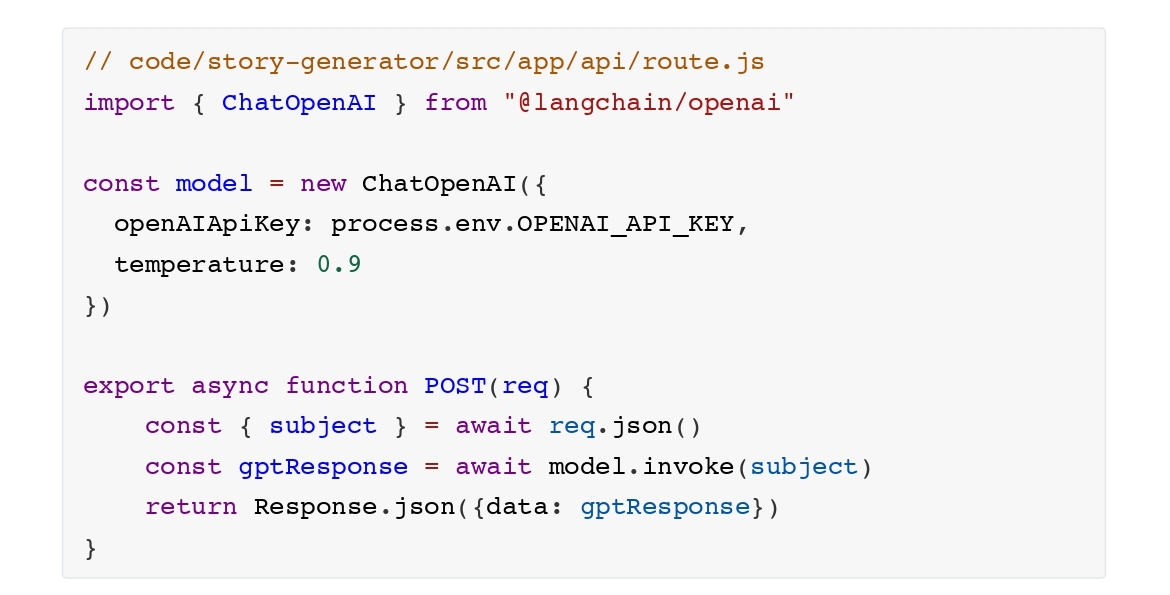

Hãy di chuyển lên bằng cách thiết lập một kết nối tới OpenAI’s LLM. Thêm code sau vào backend của app, trong file

src/app/api/route.js:

Để khởi tạo một kết nối với OpenAI, chúng ta tạo một thực thể khởi tạo mới của ChatOpenAI object. Bên trong

constructor của nó, chúng ta định nghĩa cái sau:

+ Một tham số temperature, thiết lập thành 0.9

+ API key giành từ học phần trước

Bạn có thể tò mò về tham số temperature này, đúng không?

Tham số temperature ảnh hưởng đến mô hình của chúng có sức tưởng tượng như thế nào. Tăng nó dẫn đến kết quả các

đầu ra sáng tạo hơn trong khi hạ thấp nó giữ cho các trả lời có cơ sở và thực tế hơn. Gắn vào thực tế giảm nguy

cơ thiếu chính xác hay ảo tưởng từ mô hình.

Chọn temperature đúng phụ thuộc vào nhiệm vụ. Cho nghĩ nhanh story titles thu hút, một temperature cao hơn được

ưa thích hơn. Cho các nhiệm vụ nơi tính chính xác là then chốt như tóm tắt một tài liệu pháp lý, một temperature

thấp hơn là tốt hơn.

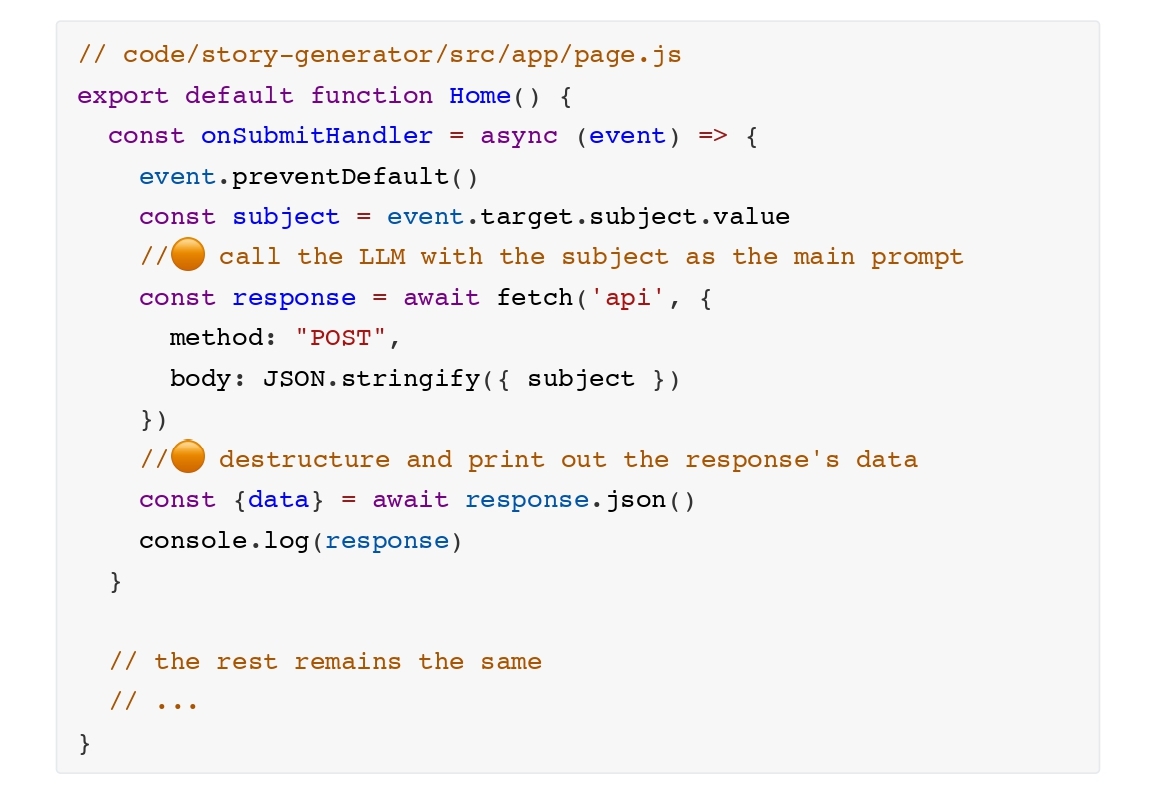

Với temperature của chúng ta được thiết lập, bây giờ hãy cập nhật frontend của app của chúng ta: